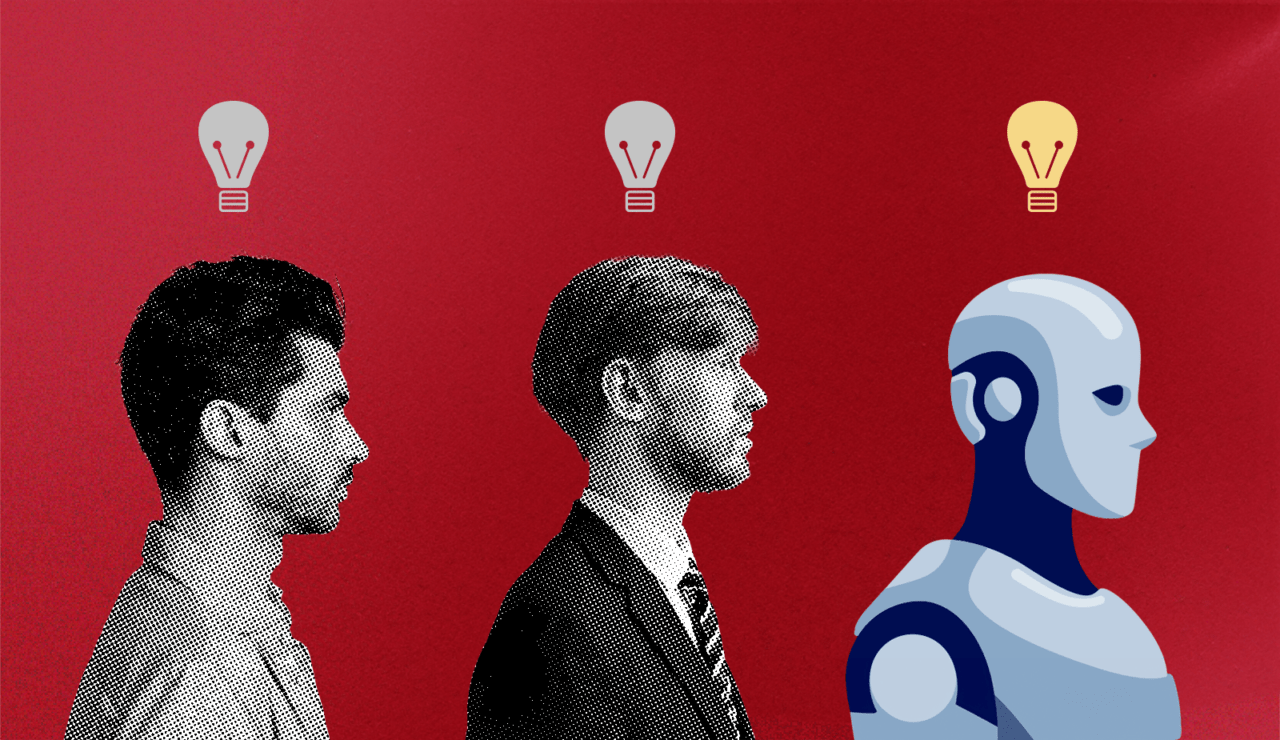

A criatividade humana e o desafio da IA

Os LLMs aumentam nossa produtividade, mas não podemos ignorar o provável preço a pagar por isso. Evitar o perigo depende de dois posicionamentos da liderança

Os sistemas generativos de inteligência artificial que modelam a linguagem vêm exibindo, de 2022 para cá, notável proficiência em uma série de tarefas. Profissionais que trabalham com escrita ou desenvolvimento de softwares que o digam.

Ferramentas como o oferecem uma maior produtividade, o que está levando muitos gestores a incorporarem essa tecnologia aos fluxos de trabalho. Mas nossa pesquisa revela que esse possível aumento de eficiência pode cobrar um preço alto.

A dependência excessiva da IA pode desestimular os funcionários de expressar seu conhecimento específico e de apresentar suas próprias ideias. Com isso, produções cada vez mais homogeneizadas tendem a ficar mais comuns.

Em longo prazo, a inovação e a originalidade ficarão ameaçadas. Os gestores que buscam obter eficiência com os grandes modelos de linguagem (LLMs, na sigla em inglês) precisarão trabalhar no equilíbrio entre a produtividade e a criatividade em sua interação com a IA.

Códigos escritos por máquina e afins

O conteúdo gerado por IA imita de maneira impressionante a fluência linguística daquele criado por humanos. Mas ele carece, em geral, das escolhas estilísticas individuais e do pensamento original que as pessoas expressariam naturalmente ao realizar uma tarefa sem IA.

Trabalhar os outputs criados pela tecnologia para que eles tragam algo mais humano (e de qualidade) pode exigir uma ação de refinamento a ser executada várias vezes – o que toma tempo. Isso levaria os usuários a decidirem que não vale o esforço, caso o output inicial da IA já for bom o suficiente.

Assim, surge o impasse. Devemos investir tempo na personalização de sugestões de IA generativa, para que ela assimile, progressivamente, seu estilo e know-how únicos, ou se contentar com o primeiro rascunho, um tanto abaixo do ideal?

Vejamos, por exemplo, uma equipe de engenheiros de software trabalhando em um projeto de tecnologia de grande escala. À medida que o grupo está na base do código, cada membro tomará decisões de codificação e documentação que estão de acordo com os padrões acordados, mas que também são orientadas pela própria experiência e preferências de cada um em relação a arquitetura de objetos, nomenclatura de funções, escolhas de teste etc.

Quando se prioriza a produtividade, as ferramentas baseadas em LLM, como o GitHub Copilot, facilitam a geração rápida de um rascunho ou o preenchimento automático de grandes blocos de código. Isso pode economizar muito tempo, já que os LLMs geralmente escrevem códigos bons o bastante.

No entanto, o primeiro rascunho da IA talvez não reflita as melhores práticas da equipe ou o domínio e o estilo de um dado engenheiro. Embora o time possa refinar seus prompts de IA ou editar o código manualmente para melhorá-lo e deixá-lo mais fiel à intenção original, isso torna o trabalho mais lento.

Não refinar/editar também pode ter implicações negativas sobre a produtividade: mais tarde, quando um programador precisar voltar ao código para corrigir um bug ou fazer melhorias, os custos e o esforço para resolver quaisquer deficiências tendem a ser muito maiores. Na verdade, nossa pesquisa descobriu que revisar e adaptar o código gerado pela IA pode ser trabalhoso demais. Em alguns casos, é mais eficiente recomeçar do zero.

O risco consequente para os gestores que colocam muito foco nas metas de produtividade e prazos difíceis de cumprir é que isso acaba estimulando os funcionários a evitarem o esforço extra e aceitarem outputs mais genéricos, o que eleva o risco de repercussões negativas significativas: um estudo de 2023 descobriu que as ferramentas de codificação baseadas em LLM podem diminuir a qualidade e dificultar a atualização do código.

Profissionais que se apoiam em ferramentas do tipo para programar já vivenciam isso. A integração da IA com pacotes de software corporativos facilitou que LLMs cumpram as tarefas de escrever e-mails, gerar relatórios ou preparar slides de apresentações.

E os usuários, nesses casos, têm de decidir entre aceitar o que a IA entrega como está (mesmo considerando que não seja suficientemente preciso ou careça de originalidade) e fazer um esforço extra para obter melhores outputs por meio de refinamentos imediatos. É provável que a pressão seja grande nesses momentos.

Quanto mais tempo os usuários gastam editando o conteúdo ou refinando prompts iterativos, mais próximo o output da ferramenta estará de suas preferências e padrões. Já se sempre aceitarem o output inicial da IA, a empresa acumulará conteúdos ou códigos que não refletem a experiência de seus funcionários.

Em um artigo para o arXiv, da Cornell University (EUA), apresentamos um modelo matemático simples adaptado para recriar e capturar aspectos-chave das interações entre humanos e IA. A seguir, resumimos o que ele nos ensina sobre as consequências da adoção indiscriminada da IA.

A criatividade está, sim, em risco

Nossa pesquisa sugere que aquilo que as pessoas ganham em eficiência ao interagir com a IA elas perdem em diversidade de pensamento e criatividade. Outputs gerados por LLMs e não modificados tendem a oferecer conteúdos mais homogêneos do que algo criado por uma pessoa real.

Imagine, por exemplo, se o Microsoft Copilot escrevesse todos os e-mails de todo mundo. Essa homogeneidade em escala pode colocar em risco a originalidade e a diversidade de ideias, algo essencial para o crescimento e a inovação.

Essa homogeneização se intensifica quando o conteúdo gerado por IA serve para treinar outros modelos de IA. A situação é mais preocupante à medida que mais conteúdo de IA chega aos conjuntos de dados usados para treinar LLMs.

Se a internet ficar saturada desse tipo de conteúdo e se a IA for cada vez mais incorporada ao nosso fluxo de trabalho, entramos em uma espiral negativa em que a criatividade e a diversidade de pensamento serão cada vez menores.

Alguns pesquisadores chegam a defender a tese de que treinar LLMs com mais conteúdo gerado por outros LLMs (não por humanos) pode levar até ao colapso desses modelos.

Você pode estar se questionando: perder diversidade de pensamento é realmente tão ruim quando ganhamos tanto em eficiência? De fato, a IA é capaz de gerar, eficientemente, uma grande quantidade de conteúdo para uso rotineiro.

A resposta é sim, ao menos no longo prazo. O hábito de adotar como padrão os outputs de LLMs tende a afetar a capacidade de inovação da empresa, uma vez que esta depende de originalidade e criatividade.

O que fazer

Os gestores devem equilibrar o foco nos ganhos de produtividade com a garantia de que as ferramentas de IA aprimorem, em vez de limitarem, as ideias e as perspectivas humanas expressas em seus produtos.

Existem ao menos duas maneiras de colher os benefícios da IA generativa sem limar a criatividade e a diversidade de pensamento, a saber:

Revisar as expectativas de produtividade. Ao avaliar o uso potencial da IA generativa para determinada tarefa, eles precisam levar em consideração a natureza e os requisitos da tarefa, quanta supervisão ela demanda ou com quanto pensamento original os funcionários devem contribuir. Em alguns casos, os funcionários podem até mesmo precisar de mais tempo para concluir a tarefa se fizerem uso de IA.

Aprimorar as interações humanos e IA. A ideia é permitir que os usuários orientem, alterem e corrijam o output do modelo com mais facilidade, pode desempenhar um papel crucial. Exemplos de medidas a tomar? Um é incentivar a geração aumentada de recuperação (ou RAG), em que a IA recorre a bases de conhecimento externas definidas para responder à demanda desses humanos. Mais treinamento em prompts também deve facilitar para os usuários humanos a transmissão de suas ideias, permitindo construir outputs de LLM mais originais.

AO LONGO DA HISTÓRIA, DECISÕES GERENCIAIS DE AUTOMAÇÃO E TERCEIRIZAÇÃO transferiram carga de trabalho e tarefas rotineiras para máquinas ou outras entidades externas. Em troca, isso permitiu que as empresas aumentassem sua produtividade e reduzissem custos.

Agora, a tecnologia de IA generativa promete fazer o mesmo, mas, diferentemente de suas predecessoras, ela afeta as empresas em um domínio diferente – o de ideias, conteúdo e inovação.

A IA pode diminuir nossa carga cognitiva em tarefas como redigir documentos de rotina ou analisar relatórios longos. Porém, corremos riscos ao lhe terceirizar nossos pensamentos originais – ou críticos.

Os líderes organizacionais devem entender que LLMs têm de ser assistentes que enriquecem o trabalho humano, não substitutos que corroem a riqueza da individualidade e da diversidade de pensamento.

Para mitigar essas preocupações, é essencial que a liderança oriente suas equipes no uso cuidadoso das ferramentas de IA. O gestor deve incentivar seus funcionários a expressarem suas próprias perspectivas e contribuírem com sua criatividade para a empresa. Isso garantirá um melhor uso dos sistemas de IA e protegerá contra as armadilhas potenciais causadas por uma cultura muito homogênea.

Leia também

Como o design thinking híbrido encurta distâncias

Repense a arquitetura organizacional e coloque o propósito em tudo

Inovadores outsiders: o que aprender com eles

O Brasil segue na contramão – e o problema é de gestão

O futuro da saúde está em tirar os hospitais do centro do atendimento

Por um RH mais estratégico

“A humanização do RH”, com Silene Rodrigues

A utilidade do conhecimento inútil, inclusive no Brasil