Os desafios legais da IA no Brasil

A imensa ansiedade em relação à inteligência artificialé justificada – são muitas tecnologias, que mudam diariamente. E a expectativa também: as oportunidades são imensas. Mas as empresas precisam ter uma política de implementação muito cara, que leve em conta as leis (e suas indefinições) e a ética

A expressão “fear of missing out” (FoMO) é utilizada frequentemente para designar o medo de ficar de fora de algo relevante. No Vale do Silício, a FoMO é apontada como um dos principais motores de um enorme ecossistema que fomenta a inovação. A disposição de bancos e _venture capitalists_ de investir em empresas que só vão gerar lucro em um futuro incerto é, em grande parte, atribuída ao medo de perder uma boa oportunidade de negócio.

Se empresas estivessem sujeitas a esse mesmo sentimento, um diagnóstico cada vez mais comum seria a FoMO relativa à inteligência artificial (IA). São frequentes informações na mídia a respeito de novas tecnologias ligadas à IA, que prometem trazer enorme impacto a todas as áreas e modelos de negócio. Estima-se que bilhões de dólares serão gerados, mas, em contrapartida, empregos desaparecerão e tecnologias atuais se tornarão obsoletas rapidamente. Essas mudanças serão tão profundas, que muitos compararam a IA aos avanços trazidos pela eletricidade no início do século 20.

A ansiedade relacionada à IA se deve, em primeiro lugar, ao fato que ela abarca uma ampla gama de tecnologias que se desenvolvem diariamente com grande velocidade. Não há uma solução que possa ser utilizada de maneira uniforme, devendo cada empresa avaliar como melhor empregar a IA de acordo com a sua estratégia, cultura e modelo de negócio.

E toda a expectativa em torno da IA é plenamente justificada. A partir da análise e do cruzamento de grandes quantidades de dados, a IA permite que se consigam informações e se façam inferências que jamais seriam obtidas por meios tradicionais. A IA permite a extração de conhecimento a partir de dados com uma velocidade e nível de complexidade inimagináveis até há pouco tempo.

Dentre as tecnologias que se valem de IA, destacam-se machine learning, deep learning e processamento de linguagem natural (NLP, na sigla em inglês). Tais tecnologias já estão disponíveis em chatbots, assistentes virtuais, smart objects, análise preditiva de dados e muitas outras aplicações. O Google Assistant, apresentado publicamente em 2018 por Sundar Pichai, CEO do Google, é um exemplo eloquente do que está por vir. Diante de centenas de pessoas, um assistente virtual que se vale de IA fez ligações para agendar compromissos e fazer reservas em restaurantes, sem que os interlocutores, em momento algum, percebessem que não estavam interagindo com uma pessoa.

Como a IA depende do tratamento de dados para funcionar, qualquer estratégia corporativa para a sua implementação deve, necessariamente, ter como base uma política clara sobre o assunto. Esses dados são a matéria prima para que algoritmos cheguem à melhor decisão, máquinas reproduzam o processo decisório de forma automatizada, chatbots atendam às demandas do consumidor e sensores instalados em máquinas interajam entre si (estamos falando da internet das coisas, ou IoT na sigla em inglês). Dados são a pedra fundamental de qualquer sistema que se utilize de IA.

Encontrar o equilíbrio entre regulação e novas tecnologias é desafiador, pois vivemos em um mundo em que há um crescente atrito entre, de um lado, normas mais restritivas para o uso de dados pessoais e, de outro, tecnologias que dependem de uma quantidade de dados significativa para funcionar.

NORMAS RESTRITIVAS

Exemplo dessa tensão pode ser extraído do Plano Nacional de Internet das Coisas 1, que tem por finalidade estabelecer as bases para a implementação da IoT no Brasil. O plano estabelece como premissas a livre circulação de dados, mas também ressalta a necessidade de observância a diretrizes de proteção de dados pessoas.

E quais seriam essas diretrizes? A mais importante é a recente Lei Geral de Proteção de Dados Pessoais (LGPD) brasileira 2, que entrará em vigor em agosto de 2020 e é fruto de um movimento internacional que busca maior transparência e segurança em relação à proteção de dados pessoais. Embora a LGPD não trate da questão da IA de forma detalhada e exaustiva, ela traz uma série de novos conceitos e princípios que terão grande impacto nessa área.

Segundo a LGPD, dado pessoal é a informação relacionada à pessoa natural identificada ou identificável. Não somente elementos óbvios como o nome, o número do RG ou número do CPF são dados pessoais, mas eventualmente também outros que permitam, se usados em conjunto, a identificação de uma pessoa. O perfil comportamental (tão comum no e-commerce e nas plataformas de streaming) pode perfeitamente ser qualificado como dado pessoal.

De acordo com a nova lei, o usuário passa a ter o direito de, a qualquer momento, ter acesso aos dados a seu respeito, bem como corrigir aqueles incompletos, inexatos ou desatualizados. Tudo com a finalidade de garantir maior controle do titular a respeito de suas informações pessoais, assim como evitar a tomada de decisões inadequadas a partir de IA.

A primeira versão da LGPD, de agosto de 2018, previa que se poderia exigir que decisões automatizadas fossem revistas por um ser humano, de forma a impedir decisões equivocadas tomadas por algoritmos. Essa previsão existe de forma semelhante na Europa, onde vigora o General Data Protection Regulation (GDPR). No entanto, a exigência foi objeto de veto presidencial na versão final da LGPD e não mais se aplica.

O veto despertou preocupação, diante do risco de que os dados nos quais os algoritmos se baseiam possam acarretar decisões até mesmo discriminatórias. Um banco que utilize algoritmo para analisar um empréstimo poderia negá-lo com base no histórico de inadimplência de determinado bairro, mesmo que a pessoa que o solicitou tenha um histórico impecável. Esse risco demonstra a necessidade de que empresas detenham informações corretas e completas e, principalmente, criem meios acessíveis para que usuários façam a gestão dos seus dados pessoais sempre que necessário.

Ainda que a LGPD não mais exija a revisão humana de decisões automatizadas, consta da lei a previsão de que o titular dos dados poderá solicitar a revisão de decisões, a qual poderá ser feita com o mesmo sistema previamente utilizado. A fim de reduzir os riscos de uma decisão incorreta, a lei prevê que tais informações devem ser prestadas de forma clara e adequada a respeito dos critérios utilizados para a tomada de decisão, respeitados os segredos comerciais e industriais da empresa.

Nada impede, naturalmente, que eventual revisão humana seja oferecida espontaneamente. E essa pode se tornar uma tendência, pois com a nova legislação é esperado que os cidadãos passem a questionar com mais frequência como os seus dados pessoais estão sendo tratados. É um processo longo, mas que já começou.

Independentemente da obrigatoriedade legal em relação a certas práticas, a expectativa é que a cultura em torno da proteção de dados mude gradualmente com a nova lei. A adoção de um plano de governança e uma política de privacidade e proteção de dados equilibrada, que proporcione ao usuário transparência e segurança, passará a ser um importante diferencial competitivo.

Outro aspecto da LGPD importante para a IA é a questão de dados anonimizados, isto é, dados relativos a titular que não possa ser mais identificado aplicando-se meios técnicos razoáveis. Os dados anonimizados deixam de ser considerados dados pessoais, podendo ser utilizados com maior liberdade em sistemas que se valem de IA.

A LGPD não indica quais meios técnicos são razoáveis para reverter a anonimização, mas essa questão poderá ser regulamentada pela recém-criada Autoridade Nacional de Proteção de Dados (ANPD). Pelo mesmo raciocínio já mencionado, recomenda-se que sejam informados com clareza ao usuário o método para a anomimização e os cuidados adotados pela empresa para que não seja revertido.

A adoção de uma política clara e medidas efetivas para proteger dados pessoais é, ainda, muito importante para mitigar eventuais penalidades decorrentes do não cumprimento das obrigações e princípios que constam da legislação. Multas elevadas e outras penas podem ser reduzidas, caso seja evidenciado que foram adotados mecanismos e procedimentos internos para o tratamento adequado de dados. É indispensável que todos esses aspectos sejam suficientemente documentados, a fim de que possam ser utilizados em discussões a respeito da responsabilidade da empresa por questões ligadas a vazamento de dados e até mesmo utilização de ferramentas de IA.

O CAMPO ÉTICO

Afora a questão estritamente legal, é importante considerar que a IA também trará desafios éticos para países e corporações. Como calibrar corretamente os algoritmos? Em que medida podem ser feitos ajustes para evitar discriminação? E ainda, até que ponto podem ser feitas inferências sobre o perfil de pessoas a partir de informações obtidas para outras finalidades? Todas são perguntas em aberto.

Com essa preocupação, a Organização para Cooperação e Desenvolvimento Econômico (OCDE) anunciou, recentemente, princípios éticos relativos à IA, os quais foram ratificados por 42 países, inclusive o Brasil.

Segundo esses princípios da OCDE, o uso da IA deve: (i) beneficiar as pessoas e o planeta, impulsionando o crescimento inclusivo, o desenvolvimento sustentável e o bem-estar; (ii) respeitar o estado de direito, os direitos humanos, os valores democráticos e a diversidade e incluir salvaguardas adequadas (por exemplo, permitindo a intervenção humana quando necessário) para garantir uma sociedade justa; (iii) garantir que as pessoas entendam quando estão interagindo com a IA e possam contestar os resultados; (iv) ter os seus riscos constantemente avaliados; e (v) buscar a responsabilização de organizações e indivíduos pela utilização adequada dessa tecnologia.

Dessa forma, além das preocupações mais objetivas relativas ao cumprimento da legislação, há questões éticas mais abrangentes que também precisam ser analisadas. Empresas devem criar mecanismos internos para endereçar essas questões levando em consideração inúmeras perspectivas. Uma abordagem estritamente comercial poderia deixar de fora temas como responsabilidade social, igualdade de gênero, entre tantos outros importantíssimos.

A legislação, até pela enorme velocidade com que a tecnologia se desenvolve, não é capaz de responder a todas às perguntas e determinar qual o melhor caminho. É desejável que seja dessa forma, pois só assim a tecnologia se desenvolve naturalmente, sem as amarras arbitrariamente estabelecidas em um momento ainda embrionário. Muitos atribuem a essa abordagem, de regulamentação posterior para deixar a tecnologia se desenvolver, a vanguarda dos Estados Unidos na área tecnológica.

Mas ainda que estejamos em um momento inicial relativo ao uso da IA, é possível afirmar que a adoção de uma política clara e balanceada relativa à proteção de dados é indispensável para que ela possa se desenvolver. Não basta a criação de uma política genérica e vaga na qual as regras e princípios sejam apenas formalmente estabelecidos, mas não sejam de fato absorvidos no dia a dia por toda a empresa.

O desenvolvimento de novas tecnologias, com uma economia cada vez mais movida por dados pessoais, exige o engajamento e o envolvimento de diferentes áreas, para que entendam o protagonismo do tema. São inúmeros os exemplos de empresas que colocam o seu futuro em xeque justamente pela falta de clareza quanto ao uso de dados de seus usuários.

A existência de normas mais protetivas e da maior fiscalização de autoridades públicas deixa claro que a falta de transparência em relação ao uso de dados terá consequências jurídicas, financeiras e reputacionais cada vez mais graves. Um plano de governança detalhado, direcionado a assegurar a privacidade e a proteção de dados pessoais, será fundamental para que a IA se desenvolva e proporcione todos os benefícios associados a ela.

Referências

[1](#_ftnref1) Decreto nº 9.854, de 25/6/2019

[2](#_ftnref3) Lei nº 13.709, de 14/8/2018″

Leia também

Como se proteger em alianças que desandam

Como o design thinking híbrido encurta distâncias

Inovadores outsiders: o que aprender com eles

O Brasil segue na contramão – e o problema é de gestão

O futuro da saúde está em tirar os hospitais do centro do atendimento

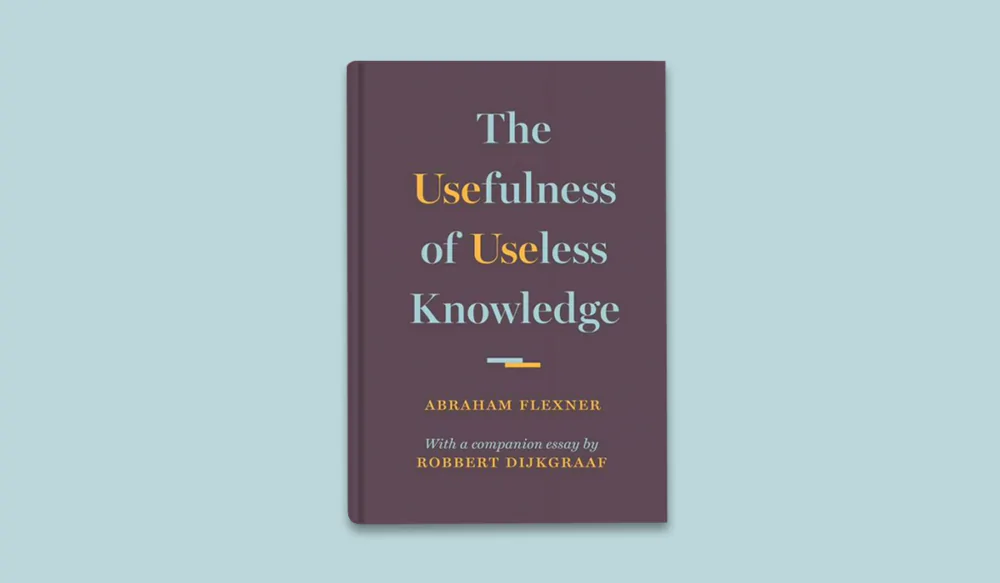

A utilidade do conhecimento inútil, inclusive no Brasil

Entre o bem, o mal e a ilusão do saber empacotado

O futuro vem do futuro #2: “Em transformação: a liderança no gerúndio”, com Daniel Martin Ely