SLMs, nossa próxima fronteira

Quem presta atenção apenas às big techs e a modelos LLM, pode estar perdendo a corrida da IA; LLMs são só a ponta do iceberg

O Banco Mundial já coloca a inteligência artificial (IA) como a principal força da quarta revolução industrial. Estudos de grandes consultorias apontam que a IA pode gerar quase US$ 20 trilhões anuais para a economia global, sendo que mais de US$ 8 trilhões vêm especificamente da IA generativa. Para efeito de comparação, o PIB do Brasil em 2023 foi de US$ 2,17 trilhões. As empresas tendem a utilizar IA generativa em tudo – processos, produtos, serviços.

Diante disso, fica evidente a importância estratégica do uso de IA e do fortalecimento de um ecossistema nacional de empresas voltado para essa tecnologia. Ignorar essa revolução industrial pode significar a estagnação econômica de um país, enquanto um investimento estruturado pode impulsioná-lo para o grupo das nações desenvolvidas. Embora esse progresso não dependa apenas das empresas – em grande parte, é condicionado por políticas públicas, regulação e incentivos ao setor –, tratamos aqui do que elas conseguem fazer hoje, quando vemos ficar mais e mais viável treinar um modelo de linguagem para chamar de seu.

Indo além das big techs em IA

Até janeiro de 2024, predominava a crença de que a corrida da IA era restrita às big techs (o Google com o Gemini, a Meta com o Llama) e a startups bilionárias (a OpenAI com o ChatGPT, a Anthropic com a Claude, a XAI com o Grok). Mas os especialistas na área sempre suspeitaram que não era um jogo só de atuais e futuras big techs; logo haveria um espaço bem mais amplo para o uso de técnicas mais otimizadas e eficientes para o treino e inferência dos modelos de linguagem que os estenderia a um número muito maior de empresas.

Com o lançamento do chinês DeepSeek R1, treinado com um investimento de apenas US$ 5,6 milhões e alcançando qualidade comparável a modelos das gigantes do setor, esse espaço mais amplo finalmente se provou viável – ou seja, outras empresas conseguem competir pelo mercado. Mesmo cabendo toda uma discussão sobre o investimento real da DeepSeek para esse treino (que poderia ser fruto de um novo artigo, inclusive), é inquestionável que há qualidade técnica em seus modelos e que houve uma mudança no patamar de custos da IA generativa nesse caso.

Para quem já atua há mais tempo na área e que já implementou centenas de projetos de IA no Brasil para as maiores empresas e órgãos públicos, como é o meu caso, estava claro que a disseminação da tecnologia não ocorreria exclusivamente por meio de grandes modelos de linguagem (LLMs, sigla em inglês que ficou mundialmente conhecida).

O grande potencial econômico da IA está concentrado em soluções específicas desenhadas para catapultar oportunidades e resolver gargalos de setores de atividade (como direito, saúde, educação) e funções corporativas (como RH, finanças, suprimentos). Essas soluções, que vão efetivamente trazer este ganho de produtividade, poderão ser realizadas por meio de LLMs próprios, agora viáveis, ou pelos por enquanto menos conhecidos SLMs (pequenos modelos de linguagem, na sigla em inglês). Este artigo argumenta que, em muitas situações, os SLMs valem mais a pena e explica o porquê.

Quando preferir modelos específicos (SLMs)

Você conhece os LLMs das big techs. São o ChatGPT-4, o Claude, o Llama. Eles estão na casa do trilhão de parâmetros e foram projetados para lidar com um vasto conjunto de informações. E, segundo a lei de escalabilidade da inteligência artificial, o aumento no tamanho do modelo e da quantidade de dados de fato melhora o desempenho geral, Por outro lado, no entanto, a escalabilidade eleva os custos computacionais de maneira exponencial.

Se você vai aplicar esses modelos a tarefas específicas, usos repetitivos e nichados, será que precisa mesmo de um modelo grande? Ou estará gerando um desperdício de capacidade computacional, de energia elétrica e dos chamados custos opex? A segunda hipótese é a correta. E, sempre que houver esse desperdício, os LLMs serão menos eficientes.

Uma forma simples de entender este desperdício de processamento e sua proporção é se perguntar: “Se minha solução de IA tem de apenas entender da legislação brasileira e identificar jurisprudências, para que eu preciso que ele seja treinado com todos os livros sobre física, química, biologia, literatura? Para que eu preciso que o modelo saiba as principais músicas mundiais e suas bandas?”. A resposta é: ”você não precisa”.

Mas, se você fizer uma pergunta sobre legislação brasileira a um LLM possui cerca de um trilhão de parâmetros– seja ele GPT, Claude, Gemini, DeepSeek, Llama ou qualquer outro –, ele vai recalcular todos eles antes de lhe dar as respostas apenas sobre direito brasileiro e suas jurisprudências. E, na prática, isso torna cada resposta até 50 vezes mais consumidora de energia elétrica (são 700 watts em média para uma resposta de LLM e 13 watts para uma de SLM) e também mais poluente do que se você tivesse feito o mesmo prompt a um modelo treinado apenas para o contexto da legislação brasileira.

Gosto de usar uma analogia do nosso dia a dia para entender esse desperdício. Você comprou produtos lácteos em um supermercado para serem entregues em sua caso. Se agisse como um LLM, o supermercado carregaria o caminhão de delivery com todos os produtos de suas prateleiras e gôndolas. Seria um enorme desperdício de custos logísticos levar todos os produtos até su casa quando tudo que você comprou foram produtos lácteos. Não seria? O que o supermercado vai fazer é agir como um SLM, separando só os produtos lácteos para levar até você. SLMs são treinados apenas com os conhecimentos que o caso de uso específico necessita. E, por isso, tendem a ser muito mais eficientes.

Uma comparação entre os modelos de linguagem

Por definição, SLMs são modelos de linguagem de até 10 bilhões de parâmetros, ou seja, duas ordens de grandeza a menos que os LLMs. Apesar de menos conhecidos do grande público, esses modelos estão ganhando destaque. A MIT Technology Review listou os SLMs entre as dez tecnologias revolucionárias para 2025 e a Forbes os apontou como a próxima grande tendência em IA dos próximos anos.

Comparando os LMs

Os pequenos modelos de linguagem (SLMs) têm até 10 bilhões de parâmetros, o que é um número significativamente menor que o dos LLMs, na casa do trilhão de parâmetros. Aqui estão comparações entre SLMs e LLMs em quatro aspectos:

🚀 1. Eficiência computacional e custo de execução

- SLMs exigem bem menos poder computacional para treinamento e inferência do que LLMs.

- SLMs consomem menos memória e energia que LLMs, sendo ideais para dispositivos embarcados ou edge computing.

- Como exigem menos hardware e energia, os SLMs reduzem custos operacionais reduzidos para as organizações na comparação com LLMs.

- SLMs são uma opção de IA generativa viável para startups e empresas de menor porte em geral; LLMs requerem investimentos em infraestrutura de IA massiva.

🔒 2. Privacidade e segurança

- SLMs podem ser executados localmente sem depender de servidores na nuvem, garantindo mais privacidade; LLMs não.

- SLMs são especialmente úteis para setores onde dados são sensíveis, como saúde e finanças.

⚡ 3. Tempo de latência e respostas mais rápidas

- Como são menores, os SLMs processam informações mais rapidamente do que os LLMs.

- Isso os torna os SLMs mais indicados do que LLMs para aplicações em tempo real como chatbots e assistentes pessoais.

🎯 4. Adaptação a aplicações e casos de uso específicos

- SLMs podem ser afinados mais rapidamente para tarefas específicas com menos dados do que os LLMs.

- Em muitas aplicações, um modelo menor bem-treinado pode superar um LLM genérico.

- SLMs são ideais para áreas específicas como saúde, educação, direito ou funções corporativas, enquanto LLMs tendem a funcionar melhor em temas abrangentes.

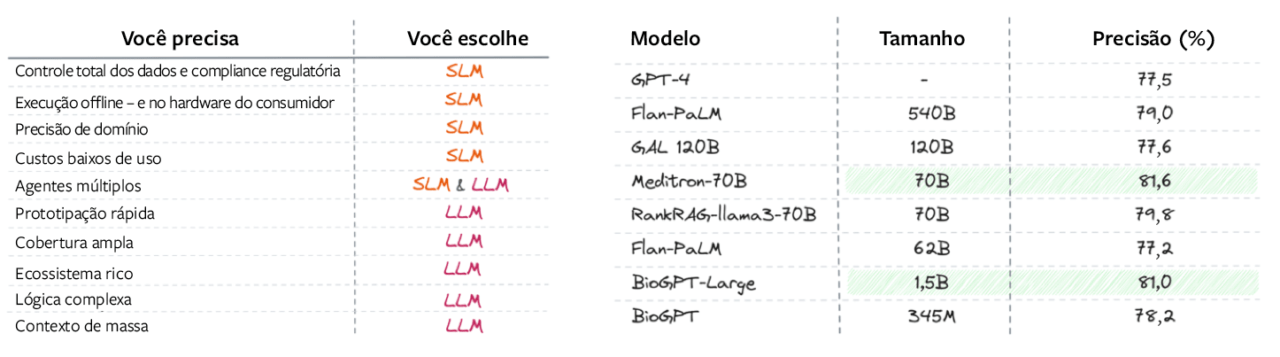

Um estudo que fizemos na Dharma-AI testou um SLM de 3,8 bilhões de parâmetros treinado especificamente para resolver provas de concurso público sobre a Constituição Federal do Brasil. Os resultados mostraram que o modelo especializado teve maior precisão e um custo operacional muito menor do que os de um LLM para a mesma tarefa [como mostra a tabela abaixo, feita pela Towards Data Science]. Isso reforça a ideia de que soluções de IA nichadas podem ser a chave para ganhos reais de eficiência e produtividade.

Comoa contece em todas as revoluções industriais, a revolução encabeçada pela IA cria uma grande oportunidade econômica e ela não será – nem deveria ser – capturada apenas pelas chamadas “magnificent 7”, grupo das sete big techs que tem dominado a indústria de tecnologia – ou não apenas pelos líderes da corrida dos LLMs. O que eu argumento é que há um espaço enorme para o desenvolvimento de um ecossistema robusto local, no Brasil, com empresas e startups que possam capturar essa oportunidade por meio de SLMs. Quão pujante e ativo será esse ecossistemas de negócios vai depender muito das regulações do setor e dos estímulos governamentais, como já foi dito, mas também da capacidade de empreender de nossas empresas.

O que organizações brasileiras podem ganhar

O Brasil tem mais vantagens do que imagina na atual corrida da IA. Possui um mercado nacional de proporções significativas, uma academia forte formando muitos engenheiros, matemáticos e cientistas da computação, e peculiaridades que abrem espaço para o desenvolvimento de um ecossistema de negócios ao redor de IA saudável e próspero. Por exemplo, as condições naturais da ausência de eventos climáticos extremos e a abundância de energia elétrica que temos, e que costumam ser o maior gargalo para a ampliação dos data centers de treinamento de IA mundo afora.

No entanto, como sabemos, essa oportunidade pode ser comprometida se as condições adequadas não estiverem presentes. Há aspectos críticos que são necessários para o desenvolvimento e o florescimento desse ecossistema, como o acesso aos dados necessários para esses SLMs. Ainda que demandem menos parâmetros, ainda precisam de dados adequados. Restrições de acesso que advenham de meios práticos ou regulatórios podem ser fatais a esse nascente ecossistema.

Para um país que deseja competir globalmente, é essencial que a infraestrutura e a regulação favoreçam a inovação, sem criar barreiras desnecessárias. O foco deve estar em fomentar um ecossistema de IA dinâmico, com startups desenvolvendo modelos especializados que impulsionem setores estratégicos. É preciso frisar que, ao promover (e regular) o desenvolvimento e o uso da IA, não devemos nos preocupar apenas com o impacto disso nas gigantes do setor de tecnologia, porque isso impacta todo o ecossistema, inclusive as startups locais de IA. E, só para deixar claro, o que estou dizendo não contradiz a máxima de que a IA seja usada com responsabilidade e ética.

Até 80% dos casos serão resolvidos por SLMs

Como o Brasil vive um dilema pela falta do aumento de sua produtividade, precisamos entender que a revolução da IA representa uma chance inédita de transformação econômica e produtiva. No mundo real, apenas 20% das demandas serão resolvidas por LLMs generalistas (a das gigantes de IA); 80% dependerão de soluções especializadas. Isso representa uma grande oportunidade para aumentar nossa produtividade, concorda?

Nesse novo cenário, empresas que souberem equilibrar o uso de LLMs e SLMs estarão mais bem preparadas para capturar valor. Aos empreendedores e executivos, digo que o momento é de experimentação e flexibilidade: é precisoavaliar diferentes modelos, testar casos de uso e otimizar custos. E ter uma arquitetura de dados que esteja preparada para lidar com múltiplos modelos.

Outra orientação essencial é: vá para a prática. Escolha bons casos de uso para testar com os LLMs e comece a usar IA de maneira corporativa. Faça MVPs – os produtos mínimos viáveis – e comprove ganhos. Então, avalie os custos de rodar em escala o MVP. Ao fazer isso, vai ser bem fácil entender se vale a pena treinar um LLM próprio ou especializar sua solução com modelos mais nichados, melhores e mais econômicos como os SLMs, fazendo disso um diferencial competitivo. Seja um protagonista nessa revolução.

Referências bibliográficas

https://www.mckinsey.com/capabilities/mckinsey-digital/our-insights/the-economic-potential-of-generative-ai-the-next-productivity-frontier#business-value

(https://www.technologyreview.com/2025/01/03/1109178/10-breakthrough-technologies-2025/

Leia também

Um guia prático para extrair valor dos LLMs

De dados a conexões: IA redefine a era dos relacionamentos

Lições da DeepSeek sobre liderança sustentável na era da IA

Esqueça a vantagem competitiva. O novo modelo de estratégia é centrado no cliente

O que é a identidade auto-soberana – e por que ela será essencial para a web3

Mudou o raciocínio: do determinístico ao probabilístico

Do “software como serviço” à “tecnologia como colega de trabalho”

Quem vai cuidar dos agentes de IA?