Análise de dados: fundamentos, técnicas e importância

Saber interpretar grandes conjuntos de informações traz vantagens estratégicas para as organizações – saiba quais são os principais conceitos e ferramentas aplicados

A análise de dados está no coração de uma estratégia cada vez mais relevante no mundo dos negócios: a tomada de decisão baseada em dados. Como uma ciência que avalia informações em estado bruto para extrair insights aplicáveis, tem sido uma ferramenta fundamental das organizações que buscam otimizar seu desempenho e descobrir novos públicos.

Em um mercado cada vez mais competitivo, a análise de dados vira um diferencial para empresas que buscam identificar tendências, entender o comportamento dos consumidores, otimizar a operação e até mesmo prever demandas futuras.

Outro fator importante para a competitividade é que a análise de dados ajuda a identificar problemas internos, como ineficiências operacionais ou falhas em processos. Assim, a empresa pode corrigi-las e seguir em frente.

O problema é que, muitas vezes, esses dados estão espalhados por toda a organização, o que dificulta a obtenção de informações integradas (ou uma interpretação mais sofisticada de indicadores de desempenho) em tempo hábil para tomar uma decisão de negócios.

Por isso, as empresas adotam a análise de dados para acessar e analisar essas informações. É uma ciência dinâmica, que evolui dia a dia, mas que parte de alguns fundamentos essenciais, que abordaremos neste artigo.

Análise de dados: fundamentos

Qualquer tipo de informação pode ser submetida a técnicas de análise de dados para obter insights que melhorem processos ou explorar novos cenários (como mercados em potencial).

Essas técnicas revelam tendências e evidências que, de outra forma, ficariam perdidas na massa de informações produzidas todos os dias – especialmente no universo de big data.

Definição de análise de dados

Quando falamos de análise de dados, estamos nos referindo a todo o processo de coletar, limpar, transformar, descrever, modelar e interpretar dados de forma sistemática. Hoje, esse processo é automatizado: são os algoritmos que trabalham sobre essas informações e trazem insights para pesquisadores e gestores.

É um campo que combina diversas disciplinas, como estatística, ciência da computação e matemática, para interpretar dados brutos e convertê-los em informação que pode ser usada tanto em pesquisas científicas como pelos negócios.

Análise de dados: história e evolução

Pode-se dizer que a história da análise de dados começa com práticas rudimentares de coleta e interpretação de informações, como nas civilizações da Mesopotâmia e do Egito, que usavam tábuas de argila para registrar transações comerciais e recenseamentos.

Mas a análise de dados que conhecemos hoje é filha do avanço da estatística no século 19, quando ela passou a ser considerada uma disciplina científica. Foi no século 20 que ela se sofisticou, especialmente com o surgimento dos computadores depois da segunda guerra mundial.

Na década de 1960 surgiram os primeiros bancos de dados relacionais, o que revolucionou a maneira como os dados eram armazenados e acessados, facilitando a recuperação e a análise de informações de maneira eficiente. Vinte anos depois, o desenvolvimento de software de planilhas eletrônicas (como o Lotus 1-2-3 e o Microsoft Excel) democratizou a análise de dados.

Chegamos ao século 21 na era do Big Data. Empresas começaram a coletar enormes volumes de dados vindos de várias fontes, como transações online, redes sociais e dispositivos conectados. Isso impulsionou a necessidade de novas ferramentas e técnicas para processar e analisar grandes conjuntos de dados.

Nos últimos anos, o aprendizado de máquina e a inteligência artificial têm desempenhado um papel crucial na evolução da análise de dados. Algoritmos de aprendizado de máquina são usados para identificar padrões complexos e fazer previsões precisas com base em grandes volumes de dados.

O futuro da análise de dados parece ainda mais promissor, com o desenvolvimento contínuo de técnicas de aprendizado profundo, análise preditiva e visualização de dados interativa. A integração de IA e análise de dados está tornando os processos mais automáticos e precisos, permitindo que as organizações tomem decisões baseadas em dados de maneira mais eficiente e estratégica.

Tipos de análise de dados

A análise de dados pode ser descritiva, diagnóstica, preditiva ou prescritiva, dependendo do objetivo e da abordagem utilizada. Ela geralmente começa pela análise descritiva, mas pode usar ferramentas avançadas (como aprendizado de máquina e aprendizado profundo) para ir além e fazer previsões ou revelar tendências.

Os quatro principais tipos de análise de dados são:

Análise de dados descritiva

Analisa os dados para examinar e compreender algo que já aconteceu. Em uma empresa, ela é usada para mostrar resultados para as partes interessadas. Ao desenvolver indicadores-chave de desempenho (KPIs), estratégias de análise descritiva apontam sucessos ou fracassos.

Exemplo: as vendas foram maiores neste mês do que no mês passado?

Análise de dados diagnóstica

Vai mais fundo e complementa a análise descritiva, buscando entender o porquê de algo ter acontecido (e identificar se um determinado resultado é, na verdade, uma anomalia). Por isso, envolve entradas de dados mais diversas e um pouco de hipóteses.

Exemplo: de que forma a mais recente campanha de marketing impactou as vendas?

Análise de dados preditiva

Baseia-se em dados históricos, tendências passadas e suposições para responder perguntas sobre o que acontecerá no futuro próximo. Para isso, as ferramentas e técnicas analíticas preditivas usam estatística e aprendizado de máquina – e recursos como redes neurais, árvores de decisão e regressão.

Exemplo: olhando modelos climáticos, podemos prever um verão mais quente neste ano?

Análise de dados prescritiva

É a que responde perguntas sobre o que deve ser feito, indicando o caminho para ações específicas para atingir metas. As técnicas de análise prescritiva dependem de estratégias de aprendizado de máquina que podem encontrar padrões em grandes conjuntos de dados.

Exemplo: se vai fazer mais calor no verão, seria uma boa adicionar um turno extra para produzir mais cerveja?

Análise de dados: metodologias

Em cada um desses tipos de análise, o processo em geral –e de maneira simplificada – segue as seguintes etapas:

Coleta de dados

As informações são captadas em um amplo leque de fontes – como computadores, internet e câmeras. Todas essas informações são então recriadas no mesmo formato para que possam ser analisadas.

Limpeza e preparação de dados

Depois, os dados passam por uma limpeza, que nada mais é do que checar se não há duplicação ou erro ou se os dados não estão incompletos. Dessa forma, eles são preparados para serem usados, por exemplo, pelas ferramentas de inteligência artificial.

Exploração de dados

Investigação inicial dos dados para entender seu conteúdo, sua estrutura e suas características, para detectar padrões, tendências e anomalias.

Leia também “Compartilhar dados é o futuro”, de Bernardo Caldeira

Modelagem e algoritmos

A modelagem é uma parte essencial da análise de dados, porque transforma dados brutos em informações que podem ser usadas para criar insights. É o processo de criar representações matemáticas ou computacionais dos dados para entender padrões, relacionamentos e comportamentos subjacentes.

A modelagem estatística busca compreender as relações entre variáveis; já a modelagem preditiva usa aprendizado de máquina e mineração de dados para criar modelos que possam prever resultados futuros com base nos dados históricos.

Interpretação de resultados

É nessa etapa que se dá sentido aos resultados obtidos pelas análises estatísticas e pela modelagem. Isso envolve examinar os outputs gerados pelas análises e traduzir esses resultados em insights.

Análise

Depois que os modelos são desenvolvidos e validados, chega o momento de interpretar os resultados de maneira que faça sentido para os stakeholders (partes interessadas) com material de visualização, relatórios e apresentações que comunicam os insights de forma clara e acionável.

Análise de dados: técnicas e ferramentas

Ao longo de todo esse processo de análise de dados, algumas técnicas e ferramentas são utilizadas. As principais são:

Técnicas estatísticas para análise de dados

A estatística é um ramo da matemática que estuda e manipula dados para representar características específicas. Dessa forma, é possível analisar dados e tirar conclusões. Algumas aplicações da estatística em análise de dados são:

- Teste de hipóteses: para saber o quão estatisticamente significativa é uma descoberta.

- Distribuição de probabilidade e estimativa: aplicar métodos estatísticos a dados ajudar a criar uma distribuição de probabilidade e estimativa.

- Criação de algoritmos de aprendizagem: para atender às necessidades de análise de dados.

- Previsão e classificação: a estatística é uma ferramenta de previsão e classificação de dados.

- Determinação de probabilidade: usa fórmulas para definir probabilidade.

Mineração de dados

É o processo de pesquisar e analisar grandes conjuntos de dados brutos para identificar padrões e extrair informações úteis. Para isso, conta com o aprendizado de máquina e a análise estatística para descobrir esses padrões e outras informações. Na análise de dados, essa técnica pode ser usada para descrever o conjunto de dados ou para prever resultados usando algoritmos de aprendizado de máquina.

Para isso, a mineração organiza e filtra dados, trazendo à tona as informações mais úteis. As organizações usam software de mineração de dados para, por exemplo, aprender mais sobre seus clientes a partir das informações que podem coletar – e, assim, planejar estratégias de marketing de forma mais assertiva, por exemplo.

Análise de dados e aprendizado de máquina (Machine Learning)

Machine learning – uma maneira de usar a inteligência artificial – é a capacidade que uma máquina tem de imitar o comportamento humano inteligente. Segundo um dos pioneiros da IA, Arthur Samuel, é “o campo de estudo que dá ao computador a capacidade de aprender sem ser explicitamente programado”.

Se formos comparar com a panificação – como Mikey Shulman, palestrante do MIT Sloan e chefe de aprendizado de máquina da Kensho –, programar um computador ou “software 1.0” é dar uma receita com as quantidades precisas de ingredientes, explicando aos padeiros o modo de preparo.

Já o aprendizado de máquina deixa o computador aprender a se programar pela experiência acumulada. Depois de fornecer e preparar dados (números, fotos, textos, transações), eles são usados para treinar a máquina, e ela então aprende como deve agir.

O modelo vai treinar a si mesmo para encontrar padrões ou fazer previsões –e pode ser ajustado por programadores no meio do caminho, para trazer resultados mais precisos.

Os modelos de aprendizado de máquina podem ser:

- Supervisionado: é o mais comum, no qual a máquina é treinada com conjuntos de dados rotulados por pessoas – como fotos de cães que ela, com o tempo, aprende a identificar.

- Não supervisionado: é o programa que procura padrões em dados não rotulados – e pode encontrar padrões ou tendências que as pessoas não estão procurando (como analisar dados de vendas online e descobrir diferentes tipos de cliente fazendo compras).

- Por reforço: treina a máquina por tentativa e erro, para que ela aprenda a tomar a melhor decisão (com um sistema de recompensa). Pode ser usado para treinar, por exemplo, veículos autônomos, explicando à máquina quando ela tomou as decisões certas.

Ferramentas de visualização de dados

A visualização de dados é a representação gráfica de informações usando elementos visuais como gráficos e mapas. É uma estratégia de comunicação visual essencial para simplificar a maneira de ver e entender tendências e padrões, por exemplo, e de transmitir essas informações às partes interessadas de maneira mais acessível.

Para transformar dados complexos nessa representação visual, em geral são utilizadas ferramentas como:

- Tableau

- Sisense

- Looker

- Microsoft Power BI

- Infogram

- Google Charts

Análise de dados: aplicações nas empresas

Análise de dados em marketing e vendas

Na área de marketing, a análise de dados ajuda a compreender as necessidades e o comportamento dos clientes e pode orientar campanhas e identificar novos públicos. E pode ser usada para:

- Segmentação de clientes, usando dados demográficos para criar campanhas direcionadas ou entendendo seus padrões de compra para identificar diferentes segmentos de clientes e personalizar ofertas.

- Otimização de mídia: analisando o retorno sobre investimento (ROI) de diferentes canais de marketing para otimizar a alocação de orçamento.

- Previsão de tendências: a análise preditiva antecipa tendências de mercado e comportamento do consumidor.

- Planejamento de produtos: identificando produtos ou serviços que estão ganhando popularidade e ajustando a oferta da empresa.

- Medir a efetividade de campanhas: é possível mensurar indicadores de desempenho (KPIs) ou realizar testes A/B para determinar quais variações de campanhas são mais eficazes.

- Identificação de oportunidades de vendas: dados podem ser usados no lead scoring para pontuar leads com base na probabilidade de conversão (para focar nos leads mais promissores).

- Previsão de vendas: modelos preditivos podem prever vendas futuras com base em dados históricos.

Leia também: “A importância dos dados para ter vantagem competitiva”, de Pedro Nascimento

Análise de dados na gestão de operações

A análise de dados também é uma ferramenta de gestão de operações. Seus insights podem ser usados para melhorar a eficiência da organização, reduzir custos e aumentar a produtividade. Para isso, ela pode ser usada em:

- Gestão de estoque e supply chain: modelos preditivos podem antecipar a demanda futura de produtos para planejar os níveis de estoque com maior precisão.

- Melhoria de processos: a análise de dados identifica gargalos na operação e identifica processos que podem ser automatizados para a aumentar a eficiência.

- Manutenção preditiva: sensores monitoram equipamentos e podem prever falhas antes que elas aconteçam.

- Gestão de qualidade: o controle estatístico de processos detecta desvios de qualidade e permite fazer a correção mais rapidamente, e a análise de dados identifica as causas de defeitos ou problemas de qualidade.

- Otimização de pessoal: a análise de dados de produção e demanda orienta a alocação correta de funcionários para atender às necessidades.

- Gestão financeira operacional: a análise de custos operacionais aponta onde é possível reduzir despesas sem comprometer a qualidade; dados históricos e preditivos ajudam a elaborar orçamentos mais precisos.

- Planejamento e execução de projetos: ferramentas que monitoram o progresso dos projetos para prever riscos e ajustar o cronograma conforme necessário.

Análise de dados em finanças e contabilidade

A área de finanças e contabilidade pode operar de maneira mais estratégica e eficiente a partir dos insights trazidos pela análise de dados. Algumas das aplicações nesse setor são:

- Planejamento financeiro: modelos preditivos são capazes de estimar receitas futuras com base em dados históricos de vendas, tendências de mercado e indicadores econômicos.

- Orçamento: analisando dados financeiros é possível criar orçamentos mais precisos, considerando variáveis como despesas operacionais, receitas esperadas e investimentos planejados.

- Análise de desempenho financeiro: usa dados para monitorar indicadores-chave de desempenho (KPIs), avaliar a saúde financeira da empresa e comparar seu desempenho financeiro ao da concorrência.

- Gestão de fluxo de caixa: a análise de dados prevê entradas e saídas de caixa para que a empresa tenha liquidez suficiente –e monitora o ciclo de conversão de caixa para identificar oportunidades de otimizar a gestão de capital de giro.

- Gestão de riscos financeiros: avaliando dados de clientes e histórico de pagamentos, dá para determinar a probabilidade de inadimplência e ajustar as políticas de crédito.

- Compliance: machine learning e análise estatística podem ser usados para identificar padrões anômalos que indiquem fraudes financeiras; sistemas de monitoramento contínuo verificam automaticamente as transações financeiras para garantir conformidade com regulamentações e políticas internas.

Análise de dados em recursos humanos

A gestão de pessoas e até da cultura corporativa também pode se beneficiar do uso de análise de dados em tarefas como:

- Recrutamento e seleção: algoritmos são treinados para filtrar currículos e identificar candidatos com maior probabilidade de sucesso com base em habilidades, experiências e qualificações.

- Previsão de desempenho: a análise de dados históricos de desempenho de funcionários ajuda a prever quais têm maior potencial de se destacar em suas funções.

- Gestão de talentos: os modelos podem ser usados para analisar informações sobre as competências dos funcionários e identificar lacunas de habilidades para planejar programas de treinamento e desenvolvimento.

- Engajamento e retenção: a análise de pesquisas de clima organizacional, de avaliações de desempenho e de comentários em plataformas internas mede o engajamento e a satisfação na empresa.

- Previsão de turnover: usando modelos preditivos é possível identificar fatores que contribuem para a rotatividade de funcionários e prever quais colaboradores têm risco maior de deixar a empresa.

- Gestão de desempenho: ao definir e monitorar indicadores-chave de desempenho (KPIs), pode-se avaliar a produtividade e a qualidade do trabalho.

- Análise de diversidade: dados demográficos revelam a diversidade da força de trabalho e identifica quais são as áreas que ainda precisam melhorar nesse quesito.

- Otimização de remuneração e benefícios: além de fazer uma análise de competitividade salarial, é possível analisar as preferências dos funcionários para personalizar pacotes de benefícios.

- Planejamento da força de trabalho: a análise preditiva antecipa necessidades futuras de pessoal com base no crescimento projetado, nas movimentações de funcionários e nas mudanças no mercado.

- Análise de cultura: a interpretação de dados de feedback e desempenho ajuda a fortalecer a cultura organizacional, alinhando-a com os objetivos estratégicos da empresa.

Análise de dados: desafios e boas práticas

Apenas 20% dos insights trazidos pela análise de dados vão trazer resultados para as empresas, de acordo com uma pesquisa realizada pela Gartner com o cenário para 2022. Isso acontece porque a maioria das organizações não segue boas práticas, segundo um artigo publicado na MIT Sloan Review Management (em inglês) que recomenda se basear em três pilares:

- Conciliando as perguntas feitas pelo negócio com os tipos de dados necessários para obter as respostas –que, por sua vez, vão determinar qual é o melhor modelo de análise de dados para obter os insights esperados.

- Ter uma fonte de dados estratégica e, se não houver informações suficientes, combinar dados próprios com aquisição de terceiros ou usar aprendizado de máquina para ajustar o conjunto de dados existente para análise.

- Mudar o foco de projetos analíticos (finitos e táticos) para produtos analíticos que são escaláveis e melhoram o desempenho.

Qualidade dos dados

A qualidade dos dados é essencial para que a análise traga informações confiáveis e adequadas para a tomada de decisão. Usar dados de baixa qualidade prejudica os insights, que acabarão se aproximando mais da adivinhação. Daí a importância de coletar dados confiáveis e de atualizar os registros existentes (de clientes, por exemplo).

Olhando para a concorrência, zelar pela qualidade dos dados é uma maneira de identificar tendências e mudanças no mercado com mais antecedência e aproveitar novas oportunidades ou enfrentando desafios antes dos concorrentes.

Ao checar a qualidade dos dados, é preciso avaliar até que ponto um conjunto de dados atende aos padrões estabelecidos de precisão, consistência, confiabilidade, integridade e pontualidade.

O gerenciamento da qualidade dos dados, portanto, envolve processos contínuos para identificar e corrigir erros, inconsistências e imprecisões. E deve ser um elemento-chave da estrutura de governança de dados de uma organização.

Segurança e privacidade na análise de dados

Para garantir a segurança dos dados, é preciso protegê-los com ferramentas que defendem a organização de ataques, ransomware, roubo de dados e outras atividades maliciosas. Com a crescente complexidade da proteção de dados armazenados na nuvem, a proteção dos dados virou prioridade, uma vez que falhas podem resultar em perdas financeiras significativas e problemas organizacionais, incluindo multas e restrições por não cumprir as regras de proteção e privacidade de dados.

As ferramentas de segurança e privacidade de dados devem ser aplicadas em três estágios:

- Fontes de dados (dados não estruturados que entram no sistema).

- Dados armazenados (localmente ou na nuvem).

- Dados de saída (usados em aplicativos ou relatórios).

Alguns dos maiores desafios em segurança de dados são a geração de dados, a falha na limpeza de dados, problemas com a mineração de dados e com o mascaramento de dados (que deve ser irreversível para garantir a segurança das informações confidenciais).

Além disso, pode haver fraude cometida por funcionários (como roubo de dados) e ataques a modelos de aprendizado de máquina, que corrompem dados treinados, especialmente em chatbots.

Para evitar essas ameaças, as organizações podem recorrer a tecnologias de segurança de dados como:

- Criptografia

- Controle de acesso de usuários

- Proteção de dados não-relacionais (armazenamento e logs de transação)

- Gerenciamento centralizado de chaves

- Sistemas de detecção e prevenção de ataques

- Sistemas de segurança física (como vigilância em vídeo) para prevenir danos

Interpretação e uso ético dos dados

Perder a confiança digital dos consumidores – que esperam que as informações pessoais fornecidas sejam protegidas e usadas de maneira íntegra – pode ser uma ameaça grave ao futuro das organizações.

Outro risco é que os modelos de machine learning podem ser treinados, mesmo não-intencionalmente, com dados históricos que contêm preconceitos. Por isso, o gerenciamento ético dos dados é crítico para as empresas.

Em um artigo publicado na MIT Sloan Management Review (em inglês), Hannah Jo Uy aponta alguns caminhos para a interpretação e o uso ético de dados:

- Estabelecer processos para responsabilização e transparência em todos os projetos de IA.

- Desenvolver modelos com questões de viés e equidade em mente – e monitorar os que estão rodando.

- Fazer um ajuste fino de sistemas de IA que usam dados na empresa.

- Realizar uma curadoria cuidadosa dos conjuntos de dados para evitar a divulgação de informações pessoais e possíveis vieses.

Futuro da análise de dados

Tendências e inovações

No início de 2024, algumas tendências em análise de dados foram apontadas por Thomas H. Davenport, pesquisador associado do MIT e conselheiro sênior do Programa de Chief Data and Analytics Officer da Deloitte, em um artigo que ele escreveu para a MIT Sloan Management Review com Randy Bean, autor de “Fail Fast, Learn Faster: Lessons in Data-Driven Leadership in an Age of Disruption, Big Data, and AI”.

Primeiro, os autores destacam que a ciência de dados está deixando de ser artesanal e se tornando industrial, pois as organizações querem acelerar a produção de modelos. “As empresas estão investindo em plataformas, processos e metodologias, lojas de recursos, sistemas de operações de aprendizado de máquina (MLOps) e outras ferramentas para aumentar a produtividade e as taxas de implantação”, escrevem os autores.

Se antes as organizações contratavam fornecedores externos, agora passam a desenvolver suas próprias plataformas para reaproveitar conjuntos de dados existentes, recursos ou variáveis e até mesmo modelos inteiros.

Para os autores, os cientistas de dados se tornarão menos atraentes. Eles podem perder espaço com o avanço de funções que podem abordar partes da análise de dados nas organizações (como engenheiros de dados, engenheiros de aprendizado de máquina, tradutores e conectores, além de gerentes de produtos de dados para supervisionar a iniciativa como um todo).

“Outro fator que está reduzindo a demanda por cientistas de dados profissionais é o surgimento da ciência de dados cidadã, onde pessoas de negócios com conhecimento quantitativo criam modelos ou algoritmos por conta própria”, afirmam os autores. “Desenvolver algoritmos inteiramente novos ou interpretar como modelos complexos funcionam, por exemplo, são tarefas que não desapareceram. O papel do cientista de dados ainda será necessário, mas talvez não tanto quanto antes.”

Leia também: “Os riscos e as tendências do mundo dos dados”, entrevista com Iain Brown

Outra tendência é que líderes de dados, análises e IA estão se tornando menos independentes. As funções desempenhadas pelos executivos de dados e análises estão sendo cada vez mais incorporadas a um conjunto mais amplo de funções de tecnologia, dados e transformação digital, que por sua vez são administradas por um “super líder de tecnologia” – que geralmente se reporta ao CEO.

“Em 2024, veremos mais desses líderes de tecnologia abrangentes. Eles ainda precisarão enfatizar análises e IA porque é assim que as organizações interpretam os dados e criam valor”, avaliam os autores. “O mais importante é que esses líderes precisarão ser altamente orientados para os negócios, capazes de debater estratégias com seus colegas de alta gestão e de traduzir isso em sistemas e insights que transformem essa estratégia em realidade.”

O papel da inteligência artificial na análise de dados

A inteligência artificial tem um papel fundamental na análise de dados. A IA permite a automação de tarefas repetitivas e rotineiras na análise de dados, como limpeza e preparação de dados, o que reduz o tempo e o esforço manual necessários para preparar dados para análise –e permite que os analistas se concentrem em tarefas mais estratégicas.

Na análise preditiva, são os algoritmos de IA (especialmente os de aprendizado de máquina) que identificam padrões e tendências em grandes volumes de dados para fazer previsões e recomendações baseadas em dados históricos e tendências atuais.

A IA também entra em campo para detectar anomalias e padrões inesperados nos dados, que podem indicar problemas, como fraudes. E na análise de sentimento das comunicações, como avaliações de clientes, postagens em redes sociais e pesquisas de mercado, para que as organizações entendam a percepção dos clientes e reajam a tendências emergentes.

Algoritmos de recomendação baseados em IA analisam o comportamento e as preferências dos usuários para fornecer sugestões personalizadas (como em plataformas de streaming). Além disso, a IA usa Processamento de Linguagem Natural (PLN) para interpretar dados textuais e extrair informações relevantes de grandes volumes de texto (como e-mails, artigos e documentos), facilitando a análise de dados não estruturados.

Na hora de apresentar os insights às partes interessadas, a IA também é usada para criar visualizações de dados dinâmicas e interativas para que os usuários possam explorar e entender melhor os dados.

Para problemas complexos, a IA pode modelar e simular cenários para prever o impacto de diferentes variáveis – o que é útil em áreas como finanças, logística e planejamento estratégico.

Conclusão

Nas organizações, a análise de dados é central para a tomada de decisão baseada em dados, pois permite avaliar informações brutas para extrair insights para melhorar o desempenho dos negócios.

O desafio é que esses dados muitas vezes estão dispersos, dificultando a integração e a interpretação rápida para decisões eficazes. Para superá-lo, entra em cena a análise de dados, que acessa e explora informações utilizando fundamentos e técnicas específicos.

Os principais tipos de análise são descritiva, diagnóstica, preditiva e prescritiva. A análise descritiva examina o que aconteceu, a diagnóstica investiga por que algo ocorreu, a preditiva prevê futuros eventos baseando-se em dados históricos, e a prescritiva sugere ações a serem tomadas.

O processo de análise de dados inclui coleta, limpeza, exploração, modelagem e interpretação. Técnicas como estatística, mineração de dados e aprendizado de máquina são fundamentais, permitindo desde a previsão e classificação até a descoberta de padrões complexos. No final, ferramentas de visualização ajudam a comunicar insights de forma clara.

O futuro da análise de dados aponta para uma maior automação e integração com IA, que facilita tarefas repetitivas, melhora a precisão das previsões e personaliza recomendações, entre outras funções.

Se você deseja aprimorar a tomada de decisões estratégicas em sua empresa com base em dados concretos, confira nosso ebook exclusivo: “O uso de dados nas decisões estratégicas“.

Este material, desenvolvido em parceria com a SAS, reúne artigos que fazem parte do Fórum Data Science para levar você a navegar pelo universo dos dados e saber como eles são usados em diferentes setores. Clique aqui para acessar o e-book agora!

Leia também

Conhecimento é poder? Hoje, só com letramento em IA

A utilidade do conhecimento inútil, inclusive no Brasil

Entre o bem, o mal e a ilusão do saber empacotado

O futuro vem do futuro #2: “Em transformação: a liderança no gerúndio”, com Daniel Martin Ely

Experiência digital: uma aliada para o futuro dos negócios

Visão sistêmica: como estruturar empresas para um futuro sustentável

O império da personalização – e o que vem depois

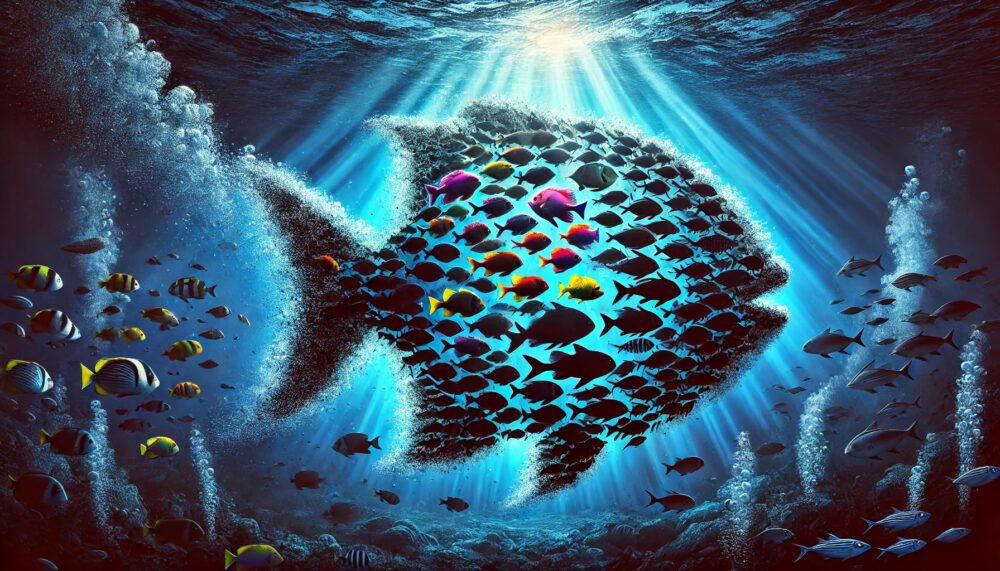

Competição em rede: por que o próximo peixe grande será um ecossistema?

2 Trackbacks and Pingbacks