ChatGPT (ainda) não consegue entender o significado das palavras

Apesar da IA ser capaz de dar respostas complexas e coerentes através do processo computacional “embedding”, a ferramenta não é capaz de entender as palavras que usa para responder as perguntas, só os humanos

Quem já usou aplicativos baseados em inteligência artificial (IA) generativa, como o ChatGPT, pode ter ficado com a sensação de que a IA domina a linguagem e entende o significado das palavras. Mais do que isso, parece saber exatamente o que responder, como se houvesse uma inteligência real.

É isso mesmo? Longe disso.

Entender os mecanismos que levam a inteligência artificial a dar uma resposta complexa e coerente passa pela compreensão de um processo computacional chamado “embedding”. A explicação a seguir é uma simplificação de um processo complexo.

Em 2013, pesquisadores do Google publicaram um estudo explicando a técnica Word2Vect – a “mágica” por trás da revolução da IA no processamento de textos. Essa técnica transforma palavras em números. A partir do processamento de bilhões de textos, esses números vão para um espaço virtual (chamado embedding space), onde são vetorizados e conectados a palavras correlatas. Complicado?

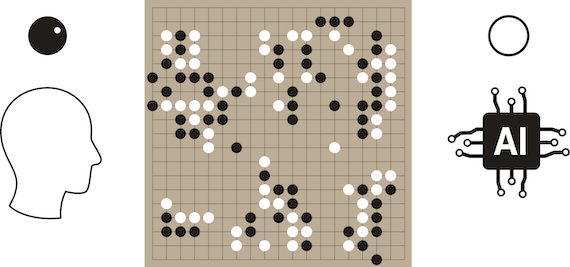

Pense nas palavras “rei” e “rainha”: elas têm relação entre elas e com outras, como “realeza”, “Estado”, “governo”, “gênero”, “homem” e “mulher”. Após processarem inúmeros textos que contêm as palavras “rei” e “rainha”, a IA “vetoriza” essas duas palavras – além das palavras correlatas. A IA liga as palavras umas às outras, criando relações de proximidade entre elas.

Por exemplo: rei → gênero → masculino → governo → monarquia. Agora, imagine que há uma quantidade imensa de palavras/vetores ligadas umas às outras. Essa vetorização ocorre num ambiente multidimensional que abrange as relações que cada palavra pode ter com outras centenas de palavras.

Uma boa forma de visualizar esse ambiente é imaginar um emaranhado de setas (os vetores, que se representam como números nesse espaço dimensional) conectadas entre si formando conceitos complexos. As mais próximas guardam maior relação entre elas. Importante lembrar que os computadores são excelentes em lógica e em processamento de números.

O posicionamento das palavras/vetores e a distância entre elas permitem à inteligência artificial “situar” os conceitos. No caso acima, rei está ligado ao masculino e à uma forma de governo, que é a monarquia – e daí em diante.E como a IA dá uma resposta complexa? Afinal, se alguém perguntar ao ChatGPT “o que é um rei?”, ele dará uma resposta que vai muito além de uma simples definição de dicionário. E essa resposta não está armazenada em sua “memória”.

O processamento de grandes quantidades de texto forma um emaranhado de vetores e agrupamentos, que podemos interpretar como conceitos complexos.

E aqui está o “pulo do gato”: para a IA, pouco importa se estamos fazendo uma pergunta ou uma afirmação. O ChatGPT, como outro aplicativo de IA generativa, é uma espécie de calculadora de palavras e frases que atua segundo regras de probabilidade. A IA apenas completa a frase dada por nós com as palavras que têm maior probabilidade de aparecer em seguida. A IA pega a frase ou pergunta feita, transforma as palavras em vetores e, com base no seu aprendizado, calcula o que deve aparecer em seguida. É como se nossas palavras transformadas em vetores formassem um caminho dentro do emaranhado de conceitos, e a IA “simplesmente” segue esse caminho que nós começamos com nosso texto. Como há uma imensa quantidade de vetores, existem inúmeras possibilidades de resposta. A IA pode “escolher” caminhos diferentes. Isso dá espaço para o que podemos considerar como criatividade na resposta, mas também abre espaço para erros (o que os especialistas chamam de alucinações).

Na prática, a inteligência artificial não tem ideia do significado por trás de cada palavra. Ela não “sabe” que rei significa “chefe de estado investido de realeza” (uma das definições dadas pelo Houaiss). A transformação das palavras em vetores torna dispensável a compreensão do seu significado.

A resposta dada nada mais é do que resultado de combinações probabilísticas.Da mesma forma que uma simples calculadora não é dotada de inteligência abstrata, um aplicativo de processamento de textos não domina conceitos que, até onde sabemos, só têm real significado para uma única espécie de ser vivo – o homo sapiens.

Leia também

“Estamos usando IA demais?” – Uma conversa com Jeremy Kahn

Data fabric e IA generativa: a revolução na gestão de dados?

Privacidade e proteção de dados na era da inteligência artificial

Vício em telas, um problema cada vez maior no Brasil

Build the future: adaptabilidade e responsabilidade na era da IA

A oportunidade que temos com a transformação alavancada pela IA

As perguntas que você deveria fazer sobre IA para o planejamento de 2025

IA e dados na saúde: desafios e oportunidades