Social UX: as contradições sociológicas no uso de IA

Ferramentas e soluções de inteligência artificial devem reproduzir nossos comportamentos ou precisam ser treinadas para corrigir os erros que cometemos no dia a dia? Artigo analisa o tema e questiona os processos lógicos em IA

Nos últimos anos, muito tem sido discutido sobre a aplicação de novas técnicas de inteligência artificial (IA) e o impacto dessa tecnologia no mercado de trabalho, na educação e nos governos. Contudo, a IA vai muito além desses aspectos; falar dela apenas no aspecto tecnológico é arranhar a superfície de um grande iceberg.

Pensar em inteligência, seja ela humana ou artificial, passa por aspectos profundos da filosofia, sendo o entendimento de tais detalhes algo fundamental para o processo de adoção da tecnologia. A experiência de usuário (UX) da IA está mais para um design sociológico do que para apenas uma interação da máquina com o usuário.

Para o próprio termo IA cabe uma boa discussão, pois definir a inteligência humana não é um processo trivial. Estamos buscando imitá-la e pretendemos fazê-lo sob qual aspecto?

O próprio termo “”imitar”” nos leva a um paradoxo conceitual. Como insistem certos filósofos, um computador que simula o clima não faz chover e um simulador de voo não é capaz de voar de verdade. Por quais motivos, então, um computador que simule atividade mental teria que ter pensamentos reais?

Em seu artigo de 1936, Alan Turing já havia abandonado o conceito de “”igual”, mas propunha uma forma de avaliar um resultado similar por meio do conhecido teste que leva o seu nome. O jogo da imitação dos processos humanos, chamado de “”Teste de Turing”” propõe chegar aos mesmos resultados, ainda que por meios diferentes daqueles utilizados por nosso cérebro. No entanto, seria isso o suficiente para gerar confiança social?

Quando falamos de imitar, de que pensamentos estamos falando? Temos apenas um tipo de pensamento ou vários? Será que a inteligência humana é aceitável por sua eficiência e por sua humanidade?

A vida construída por algoritmos

Você provavelmente já deve ter ouvido ou lido o termo algoritmo, que nada mais é do que uma sequência para a execução de uma tarefa. Um algoritmo não precisa ser criativo ou inteligente, pois segue de forma mecânica uma sequência de regras, ainda que estas possam sofrer ajustes automatizados.

Aprendemos a resolver equações matemáticas na escola por meio de algoritmos, muitas vezes sem entender a origem e o porquê de cada ação a ser realizada: simplesmente seguimos os passos ensinados pelo professor. O fato é que tal ação, embora pareça inteligente, é mecânica, ainda que possa render pontos em provas ou exames de admissão.

Entretanto, quanto do nosso dia a dia se define por execuções algorítmicas? Dirigir um automóvel, preparar um alimento, apagar as luzes, vestir roupas, preparar o material de trabalho, fazer operações matemáticas, navegar na internet, ler um texto. Tais algoritmos nos definem como seres humanos ou seriam sinais de inteligência?

Uma resposta positiva está muito mais ligada à interpretação do que à realidade. Por exemplo: se você tem animais de estimação, provavelmente já mediu a inteligência deles para conseguirem executar algum algoritmo, como buscar uma bola ou abrir uma porta. Entretanto, se buscar bola e abrir portas não fossem ações naturais aos humanos, consideraríamos isso um sinal de inteligência?

Se as atitudes baseadas em algoritmos são parte de nossas ações humanas, tornando-se inclusive profissões, o outro lado da moeda são as ações menos mecânicas, portanto, mais subjetivas; essas geram um obstáculo filosófico ainda maior.

As ações subjetivas, embora possam ser medidas de forma mais clara por meio de seus resultados, como, por exemplo, uma obra de arte, têm como complicador o processo para se chegar à consequência. Aliás, o conceito de consciência, em geral, carece de consenso, dificultando o mapeamento, portanto, a imitação.

IA deveria imitar ou corrigir os problemas humanos?

Da economia à medicina, a busca por consenso é um grande desafio social. Em 1973, o juiz Marvin Frankel chamou a atenção para a grande diferença entre sentenças de casos similares executadas por diferentes juízes norte-americanos. A discrepância entre as sentenças aplicadas variava de sete meses a sete anos de condenação para crimes idênticos, mostrando não só um viés (quando envolvia questões raciais), mas também um ruído muito grande nos dados apresentados, já que nenhum padrão ou lógica poderia ser reconhecido.

Na economia, a falta de um consenso ainda parece ser um padrão. Diversos economistas discutem a lógica por trás da crise de 2008 sem chegar a um acordo, existindo diversas teorias sobre o que de fato originou a grande onda de desvalorização do mercado. Parece absurdo, mas não existe um consenso sobre o que de fato causou a crise econômica. O que significa que a frase: “”errar é humano” pode ser completada por “repetir o erro é ainda mais humano”.

Na medicina, como em outros domínios, podemos ver uma diversidade de tratamentos para o mesmo problema, assim como em análises de concessão de crédito, avaliações de coberturas de seguro e diversas atividades humanas. O que fazer nesses casos? Seria aceitável uma IA que imitasse tamanho ruído? Como medir os resultados que a máquina apresenta? O oposto também seria possível? Uma inteligência que eliminasse o ruído seria vista como compatível?

Isso é o que chamamos de paradoxo do Pinóquio. Assim como na história do boneco de madeira que queria ser menino, e é penalizado por uma fada por ter atitudes que só garotos reais possuem, buscamos uma IA que seja tão inteligente quanto os seres humanos, mas que não erre da mesma forma, mesmo sendo treinada por nós — que falhamos e temos vieses.

Além disso, adicionamos um agravante: com a falta de consenso, cada um julgaria o algoritmo de IA conforme a sua visão, estando esta errada para uns e certa para outros, funcionando para alguns e não para os demais. Como a fada do Pinóquio, queremos algoritmos sem falhas, desejamos carros autônomos que não erram (apesar da coleção de acidentes provocados pelos seres humanos) e adoraríamos redes sem vieses e ruídos, embora esses sejam a base de muito do que fazemos em sociedade. É possível? No mínimo uma bela discussão, e a resposta está longe de ser apenas uma questão de engenharia.

IA e a falta de lógica

O terceiro aspecto a ser analisado é ainda mais complicado, pois vai ao encontro do centro do pensamento humano, cuja estrutura segue em conflito com as técnicas atuais de IA: a lógica. Embora pareça óbvio para as pessoas leigas, a IA carece desta ciência. Tal discussão é antiga no meio da computação e o uso da lógica dentro da IA passa longe dos silogismos.

De acordo com Robert C. Moore, existem três papéis da lógica na IA: como ferramenta de análise, como base para a representação do conhecimento e como linguagem de programação. Mesmo assim, ela pouco atua no processo de conclusão, o que gera uma série de confusões para os mais leigos quando estão pensando em novas aplicações.

— “Se X é isso, então quando a IA vir Y vai saber que não é X.” — disse o cliente.

— “Não, não vai.”

Traduzindo… aquelas brincadeiras de silogismos anedóticos: se a bolacha é feita de água e sal, então o mar é um grande biscoito. Pode fazer sentido na programação e para a mente humana, mas faz pouco sentido para uma IA, sendo por isso bem mais fácil entender um software do que soluções de aprendizado de máquina.

Atualmente, as redes neurais artificiais resolvem problemas específicos, por isso são chamadas de redes “estreitas”. Não temos ainda uma IA capaz de resolver problemas de diversas frentes utilizando uma única arquitetura, que seria a IA “”geral””, ou o “santo graal” da IA. Contudo, seria possível atingirmos tal nível deixando de lado a dedução e a lógica?

Que a IA é algo que estará presente em nossas vidas de forma permanente, não há dúvidas. Atualmente, algumas soluções já não sobrevivem sem os algoritmos e muitos serviços foram criados em torno deles. A questão será como, enquanto sociedade, reagiremos ao próximo passo. Aceitaremos as evoluções que estão por vir? Teremos debates que realmente interessam ou discutiremos questões rasas que impedirão os avanços tecnológicos?

O maior medo não é termos a supremacia da máquina, mas discutirmos sua evolução como se discute hoje a circunferência da terra.

Indicações para avançarmos no tema

Sugerimos quatro leituras para ampliarmos nossos horizontes sobre o tema: The Computational Theory of Mind da revista Stanford Encyclopedia of Philosophy. O artigo foi publicado pela primeira vez em 2015 e passou por uma atualização em 2020. Da mesma publicação científica, recomendamos Animal Cognition, publicado em março do ano passado.

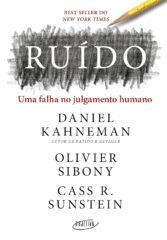

Inclusive, em 2021, chegou ao mercado editorial brasileiro uma obra que somente pelo título diz muito sobre o que abordamos neste artigo: Ruído – uma falha no julgamento humano, de Daniel Kahneman, Oliver Sibony e Cass R Sunstein; nomes que dispensam apresentações, principalmente para quem está familiarizado com pensamento estratégico, tomada de decisões e análise de comportamento.

Por fim e não menos importantes, destacamos um artigo um pouco mais antigo, de 2017, publicado no The Quarterly Journal of Economics da Oxford Academic: Credit-Market Sentiment and the Business Cycle, dos pesquisadores David López-Salido, Jeremy C. Stein e Egon Zakrajšek.

Este artigo foi escrito em parceria com Evandro Barros, CEO da DATA H e fundador do Instituto de Inteligência Artificial Aplicada.

Gostou do artigo escrito por Gustavo Meirelles e Evandro Barros? Confira outros conteúdos sobre inteligência aritficial assinando nossas newsletters e ouvindo nossos podcasts na sua plataforma de streaming favorita.“

Leia também

A IA é um cisne vermelho no mercado de soluções digitais; saiba como responder a ele

Audiência e infraestrutura: as duas grandes batalhas do mundo tech

O rio Estige da IA: fronteira entre conhecimento e sabedoria

O futuro da saúde está em tirar os hospitais do centro do atendimento

Conhecimento é poder? Hoje, só com letramento em IA

O que o mito da garagem não ensinou aos empreendedores

O império da personalização – e o que vem depois

Inteligência artificial: para onde caminha a humanidade?