O perigo de colocar a ética no piloto automático

Quando a IA generativa passa a tomar decisões pelos colaboradores, eles perdem a capacidade de refletir sobre a dimensão ética do trabalho. Uma pesquisa aponta a saída

- As lições que aprendemos com a falha global da Microsoft

- O perigo de colocar a ética no piloto automático

- Saia do automático e faça advocacy por políticas climáticas

- Também a síndrome do “não foi inventado aqui” é automação

- Lançamento traz conteúdo essencial à nova era da liderança

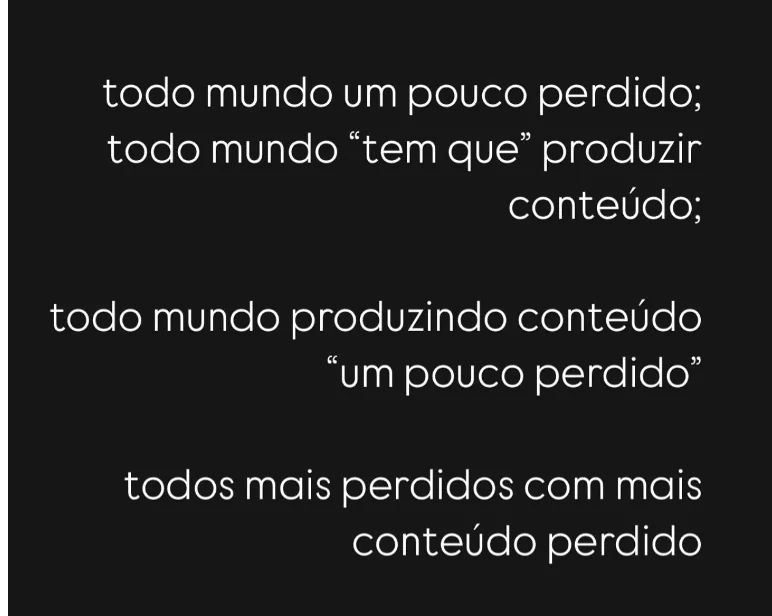

- Menos mesmice nas redes. Desenvolva seus próprios criadores de conteúdo

- Contra o olhar viciado sobre os consumidores, um design inclusivo

- Potencializando a migração para a nuvem

- Faça automação inteligente com um centro de excelência

Com o avanço da inteligência artificial generativa, os minions estão à solta. Mas não os atrapalhados asseclas amarelinhos do vilão do filme Meu Malvado Favorito – e sim a legião de assistentes automatizados que está sendo lançada no mercado. São os chatbots e copilotos que fornecedores de software estão criando com base em LLMs (os grandes modelos de linguagem) e que nos ajudam a dar conta das nossas tarefas mais simples ou trazem sugestões.

O lado bom disso é que esses novos colegas de trabalho podem aumentar a produtividade e automatizar as tarefas mais entediantes. Mas, se deixarmos eles entrarem no universo corporativo no passo atabalhoado dos minions, sem cuidado na implementação, corremos o risco de diminuir a competência dos colaboradores para tomar decisões. O que é perigoso, especialmente, quando a ética está em jogo.

Leia também

Inovadores outsiders: o que aprender com eles

O Brasil segue na contramão – e o problema é de gestão

O futuro da saúde está em tirar os hospitais do centro do atendimento

Conhecimento é poder? Hoje, só com letramento em IA

Por um RH mais estratégico

“A humanização do RH”, com Silene Rodrigues

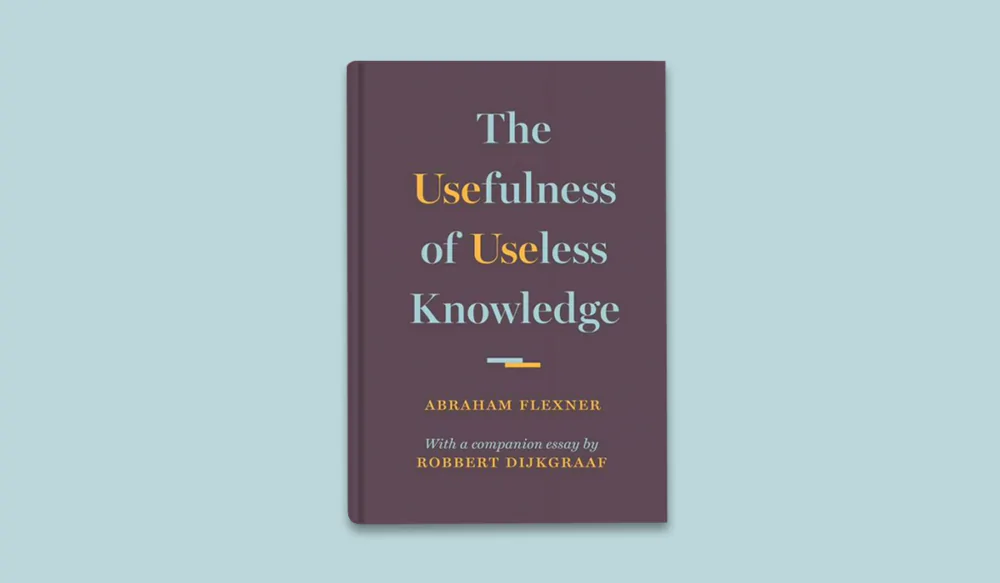

A utilidade do conhecimento inútil, inclusive no Brasil

Entre o bem, o mal e a ilusão do saber empacotado